Servidores Dedicados vs. Compartilhados: Qual é Melhor?

Índice:

A instabilidade frequente em pequenos provedores de internet pode comprometer de forma significativa operações essenciais do cotidiano das empresas, principalmente quando os recursos de hardware não foram devidamente dimensionados ou quando existe um excesso de usuários conectados simultaneamente no ambiente.

Quando não há um planejamento adequado, os serviços acabam ficando instáveis, a rede começa a apresentar congestionamentos recorrentes e, além disso, a vulnerabilidade dos sistemas aumenta consideravelmente, o que prejudica a produtividade das equipes e impacta diretamente os resultados das operações realizadas de maneira online.

Por esse motivo, a escolha do servidor mais adequado torna-se fundamental para garantir a estabilidade e o desempenho que cada tipo de negócio demanda em suas rotinas.

Nesse contexto, surge a necessidade de avaliar e comparar a utilização de um servidor dedicado ou compartilhado, já que essa decisão influencia de maneira direta a escalabilidade, a segurança e a eficiência operacional dos sistemas.

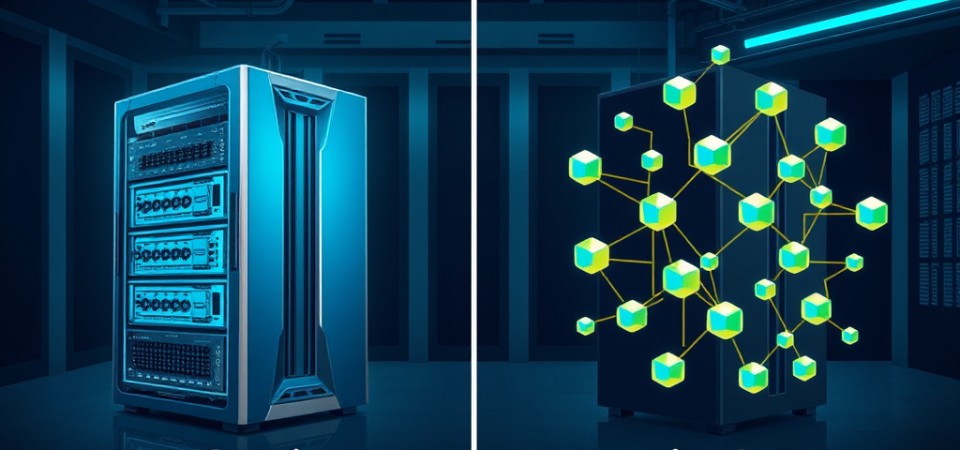

Servidores dedicados vs. compartilhados

A decisão entre optar por um servidor dedicado ou por um servidor compartilhado depende diretamente das necessidades específicas e das prioridades de cada aplicação empresarial, já que cada modelo possui características distintas.

O servidor dedicado disponibiliza recursos exclusivos, como processador, memória, armazenamento e rede, proporcionando um alto desempenho, uma segurança reforçada e liberdade total para personalizar o ambiente conforme as demandas específicas da organização.

Essa alternativa é especialmente indicada para empresas que precisam de alta disponibilidade, operam aplicações críticas ou lidam com grandes volumes de acessos simultâneos em suas plataformas.

Apesar de o custo ser mais elevado, o investimento em um ambiente dedicado se justifica pela estabilidade, pela escalabilidade e pelo controle total sobre o sistema, o que garante maior autonomia e segurança para as operações.

Por outro lado, o servidor compartilhado funciona com diversos usuários dividindo os mesmos recursos, o que reduz os custos de operação, mas limita o desempenho, a segurança e a capacidade de personalização do ambiente.

Esse tipo de solução costuma atender bem a projetos menores, com baixa demanda por processamento, porém, em situações de maior carga, os picos de uso dos outros clientes podem afetar negativamente o desempenho dos serviços hospedados.

Portanto, se a empresa busca desempenho, controle e possibilidade de expansão a longo prazo, o servidor dedicado é a alternativa mais indicada para garantir a continuidade e a qualidade dos serviços.

Por outro lado, para quem prioriza economia, simplicidade e possui demandas leves de processamento, a opção pelo servidor compartilhado pode ser suficiente para suprir as necessidades iniciais do projeto.

A arquitetura de cada solução

A arquitetura dos servidores dedicados e dos servidores compartilhados difere principalmente no nível de controle, isolamento e desempenho que cada ambiente é capaz de proporcionar ao usuário ou à equipe de TI.

Nas soluções dedicadas, recursos como processador, memória, disco e rede são exclusivos daquele cliente, o que confere um controle granular e isolamento total, favorecendo tanto a escalabilidade quanto a personalização do ambiente conforme as necessidades do negócio.

Esse tipo de arquitetura permite implementar interfaces de alta velocidade, ampliar o volume de operações por segundo (IOPS) e ainda oferece liberdade para definir topologias de rede, configurar firewalls e aplicar políticas específicas de segurança e desempenho.

Já nos servidores compartilhados, todos os recursos são distribuídos entre múltiplos usuários, o que pode ocasionar variações na taxa de transferência e impor limitações em configurações de rede, como a restrição ao uso de VLANs e ao roteamento personalizado.

Nesse modelo, o acesso aos recursos é gerenciado pelo provedor, reduzindo significativamente a autonomia do cliente e impactando o desempenho, especialmente nos horários de maior utilização.

Ambas as arquiteturas podem se beneficiar do uso de placas de rede robustas e switches redundantes, porém, a diferença essencial está no grau de controle permitido e na capacidade de isolar aplicações críticas em ambientes sob demanda.

A administração e os impactos no desempenho

A administração dos servidores dedicados acontece de forma direta, o que oferece ao cliente controle total sobre o ambiente, permitindo ajustes finos no sistema operacional, nos recursos de hardware e nas configurações de rede, sem qualquer interferência de terceiros.

Como não existe disputa por processador, memória ou armazenamento, o desempenho se mantém mais previsível e consistente ao longo do tempo, características essenciais para aplicações que envolvem bancos de dados e exigem alta performance.

Nos servidores compartilhados, por sua vez, a alocação de recursos é coletiva, o que pode gerar oscilações de desempenho conforme o uso dos demais clientes hospedados no mesmo servidor físico.

Assim, em momentos de pico, processos críticos tendem a ficar mais lentos ou até mesmo instáveis, prejudicando a produtividade das equipes e a experiência dos usuários.

Para minimizar esses efeitos, muitos provedores implementam políticas de qualidade de serviço (QoS) e realizam monitoramento ativo dos serviços hospedados, buscando garantir um desempenho mais equilibrado.

No entanto, mesmo com essas medidas, os benefícios de um ambiente dedicado não são plenamente substituídos.

Investimentos em processadores com múltiplos núcleos, memórias de alta velocidade e sistemas de cache avançados contribuem para elevar o desempenho em ambas as opções, mas os resultados costumam ser mais evidentes e sustentáveis nas arquiteturas dedicadas.

A segurança em cada cenário

O uso de protocolos de criptografia e a segmentação de rede tornam-se indispensáveis para reforçar a proteção em servidores dedicados, assegurando que os dados trafeguem de forma segura e isolada dentro do ambiente corporativo.

A implementação de políticas de acesso restrito, com controle rigoroso de permissões, reduz consideravelmente o risco de intrusões não autorizadas e de falhas humanas que possam comprometer a integridade das informações.

Já em ambientes compartilhados, os cuidados devem ser redobrados, pois a exposição a riscos é naturalmente maior devido à presença de múltiplos clientes no mesmo servidor físico.

Nesses casos, é fundamental manter um firewall interno bem configurado, aliado à análise constante dos logs de acesso e eventos, para identificar rapidamente qualquer anomalia ou tentativa de invasão.

Além disso, atualizações regulares dos sistemas operacionais são imprescindíveis para corrigir vulnerabilidades e conter ataques, como os provocados por ransomware, que podem comprometer a operação de toda a empresa.

A supervisão em tempo real desempenha papel crucial, pois permite identificar ameaças assim que surgem e agir rapidamente para evitar prejuízos financeiros e interrupções dos serviços essenciais.

Em ambos os ambientes, a adoção de metodologias específicas de verificação é essencial para preservar a integridade dos dados e garantir a continuidade operacional, independentemente do porte da empresa.

Problemas com a manutenção inadequada

Servidores dedicados e compartilhados exigem manutenção constante para assegurar tanto o desempenho quanto a segurança do ambiente de TI das empresas.

No caso dos servidores dedicados, a responsabilidade pelo monitoramento, pelas atualizações e pelas correções recai geralmente sobre a própria empresa ou sobre a equipe de TI, o que proporciona mais controle, mas também exige atenção constante para evitar falhas.

Nos servidores compartilhados, boa parte da manutenção é realizada pelo provedor de hospedagem, porém, ainda assim, é necessário acompanhar a saúde dos sistemas, realizar backups regulares e garantir a segurança das aplicações instaladas.

Quando atualizações de firmware e patches de segurança são negligenciados, as chances de falha aumentam consideravelmente, colocando em risco a operação e a integridade dos dados armazenados.

Além disso, brechas de segurança e vulnerabilidades podem ser exploradas por invasores, resultando em perda de dados, invasões ou até sequestro de informações sensíveis por ransomwares, com impacto direto nas rotinas do negócio.

Outro risco comum é a falha física dos componentes, como discos rígidos, fontes de energia ou módulos de memória, que, sem o monitoramento adequado, podem apresentar defeitos repentinos e provocar paradas prolongadas dos serviços.

Falhas no backup também se tornam mais frequentes quando não são realizados testes periódicos de integridade, aumentando o risco de perda definitiva de informações importantes.

Em situações de emergência, isso pode significar que os dados não estarão disponíveis ou íntegros, agravando ainda mais o cenário e dificultando a recuperação das operações.

A principal conclusão é que a ausência de manutenção preventiva prejudica tanto as operações quanto o desempenho do ambiente, tornando os sistemas lentos, sujeitos a gargalos de processamento e propensos a travamentos em momentos críticos, o que afeta diretamente a produtividade da equipe e a experiência dos usuários.

Como garantir mais eficiência e confiabilidade

Investir em hardware robusto, com suporte à virtualização, redundância de discos e fontes de alimentação, elimina gargalos de escalabilidade e reduz significativamente os riscos de falhas inesperadas, proporcionando um ambiente mais seguro e estável para as operações diárias.

Além disso, manter um sistema de backup local do ambiente previne surpresas desagradáveis em casos de falhas, assegurando a segurança dos arquivos e a continuidade dos negócios mesmo diante de incidentes.

Nesse contexto, uma alternativa eficaz é utilizar um backup server Qnap fornecido pela Storcenter, que combina desempenho e segurança ao oferecer recursos como replicação de dados, snapshots automáticos e um painel de gerenciamento intuitivo, facilitando o dia a dia da equipe de TI responsável pela infraestrutura.

Essas funcionalidades minimizam as perdas de dados, aumentam a resiliência da infraestrutura e prolongam sua vida útil, tornando o ambiente mais preparado para enfrentar desafios futuros.

Além do equipamento, contar com serviços completos de instalação, configuração e manutenção torna a implementação mais ágil, eficiente e livre de complicações para a equipe técnica da empresa.

Alinhamento estratégico para novas demandas

Projetos de migração ou consolidação de servidores exigem uma análise criteriosa do volume de dados, das metas da empresa e do crescimento esperado para os próximos anos, garantindo que a infraestrutura acompanhe o desenvolvimento do negócio.

O avanço tecnológico só se mantém eficiente quando a infraestrutura está pronta para crescer junto com as necessidades do negócio, evitando limitações inesperadas e gargalos que possam prejudicar a operação.

Investir em servidores preparados para alta disponibilidade protege o ambiente contra limitações inesperadas, preserva a qualidade dos serviços e evita gastos emergenciais com correções urgentes, que geralmente custam mais caro e demandam mais tempo para serem realizadas.

Uma infraestrutura bem dimensionada permite enfrentar desafios futuros com mais segurança, reunindo desempenho, proteção e flexibilidade para atender demandas cada vez mais exigentes e complexas.

Com essa visão integrada, as empresas se posicionam de maneira sólida para atender às novas demandas do mercado e garantir a continuidade do crescimento sustentável.

Dúvidas Frequentes

1- Qual o impacto na velocidade em ambientes que dividem recursos?

Em sistemas compartilhados, a concorrência por processador, memória e armazenamento pode causar lentidão significativa, principalmente nos horários de pico, quando vários usuários acessam simultaneamente os mesmos recursos disponíveis.

Essa situação gera filas de execução e instabilidades nos serviços; entretanto, com a adoção de ajustes de qualidade de serviço (QoS), isolamento de cargas críticas e monitoramento constante dos processos, é possível aprimorar o desempenho e garantir uma comunicação mais fluida e estável entre os diferentes sistemas hospedados.

2- É possível migrar aplicações críticas para uma estrutura dedicada sem longas interrupções?

Sim, é possível realizar a migração de aplicações críticas para uma estrutura dedicada sem longas interrupções, desde que haja um planejamento detalhado, replicação de dados e testes prévios para validar o funcionamento das aplicações no novo ambiente.

Utilizar snapshots e realizar validações de desempenho antes do corte definitivo asseguram que os serviços retornem rapidamente ao ar, reduzindo o tempo de indisponibilidade.

A sincronização entre as equipes envolvidas na migração evita atrasos e minimiza os riscos durante o processo de transição.

3- Como proteger os dados em ambientes com alta demanda?

A criptografia de dados em repouso e em trânsito é fundamental para garantir a segurança das informações, assim como o uso de firewalls bem configurados e sistemas de detecção de intrusões para identificar e bloquear ameaças em tempo real.

Além disso, backups constantes e atualizações regulares dos sistemas de segurança reforçam a proteção dos dados contra ataques e falhas inesperadas.

A distribuição adequada das cargas de trabalho também ajuda a evitar gargalos de processamento que podem ser explorados por invasores para comprometer a integridade dos sistemas.

4- Quais cuidados são importantes ao instalar um novo servidor?

Verificar a compatibilidade do hardware com os sistemas operacionais, drivers e aplicações desejados é essencial para evitar erros e falhas após a instalação do novo servidor.

É importante garantir que haja memória e capacidade de processamento suficientes, além de um cabeamento de rede adequado para suportar a demanda de tráfego prevista.

Adotar boas práticas, como controle de temperatura, alimentação redundante e uso de componentes certificados, contribui para prolongar a vida útil do equipamento e reduzir o risco de falhas prematuras.

5- É necessário manter suporte técnico após a instalação?

Sim, manter o suporte técnico ativo após a instalação do servidor é fundamental para prevenir impactos causados por falhas inesperadas e garantir a continuidade das operações.

Ter assistência especializada à disposição assegura correções rápidas, atualizações regulares e análises de desempenho que mantêm a estabilidade do ambiente ao longo do tempo.

Uma equipe de suporte preparada antecipa possíveis problemas, agiliza a solução de incidentes e mantém a operação segura e eficiente, protegendo os interesses da empresa.

Leia mais sobre: Servidores

Servidores

SUPORTE

Técnicos Especializados

Nossa equipe é altamente qualificada para atender a sua necessidade.